Racismo velado? Além de envelhecer, FaceApp embranquece rostos negros

O FaceApp, aplicativo russo que virou febre ao aplicar um filtro de ‘envelhecimento’, viu no último mês de julho a sua imensa popularidade se transformar numa pilha de questionamentos sobre privacidade. Existem dúvidas sobre que dados são coletados e compartilhados, além de temores sobre uma empresa russa ter um banco de rostos de 150 milhões de pessoas no mundo. Mas as práticas questionáveis da empresa não acabaram. O filtro de envelhecimento também causa o embranquecimento de rostos negros.

Publicado 04/08/2019 22:47

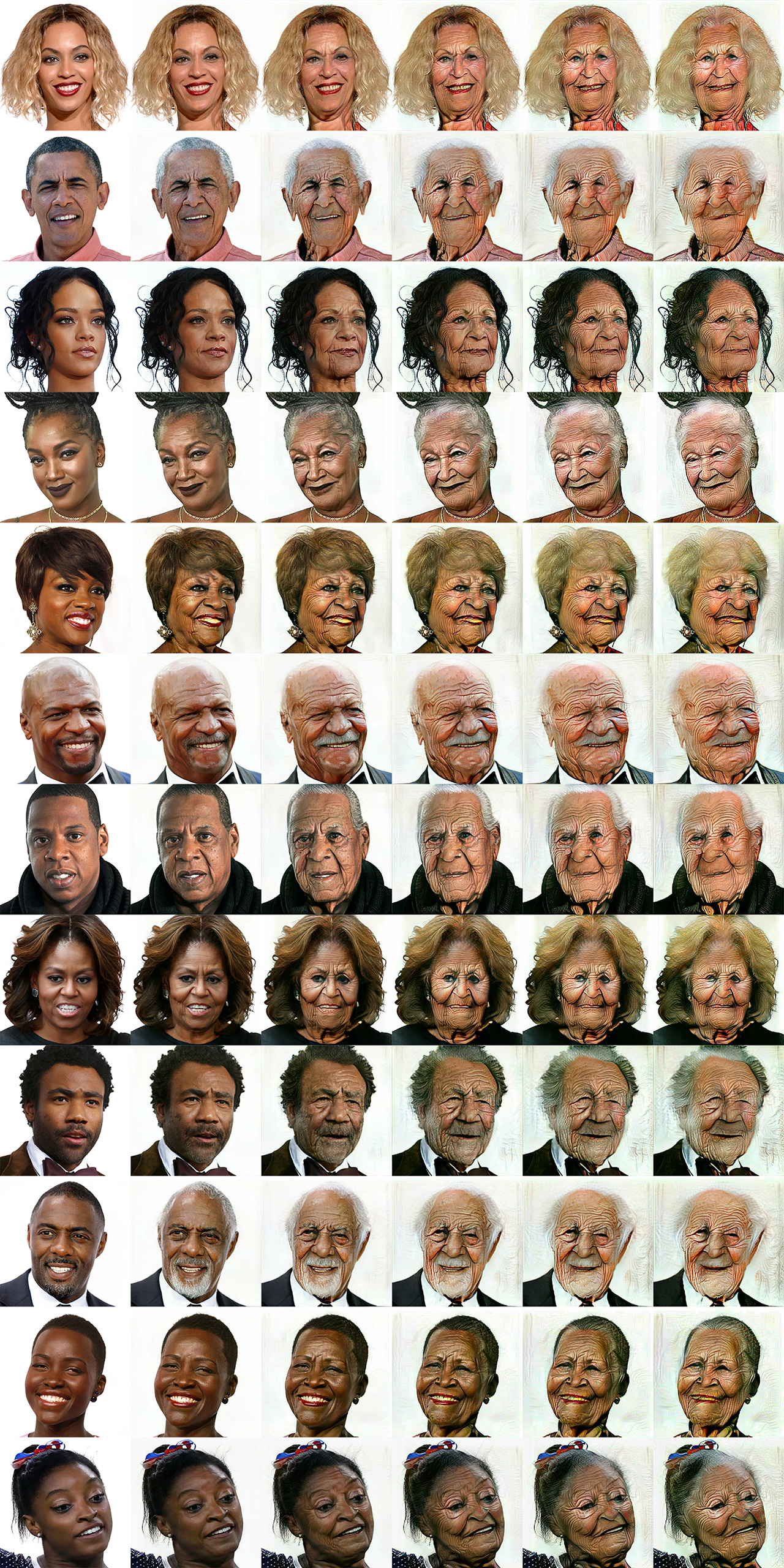

É o que aponta um experimento do jornal O Estado de S. Paulo que aplicou o filtro de envelhecimento cinco vezes na mesma imagem. Foram utilizadas fotografias de diferentes personalidades negras, como ex-presidente norte-americano Barack Obama, o rapper Jay-Z, a cantora Iza e a atriz Lupita Nyong'o. Em todas, o resultado foi parecido: apesar das distorções evidentes por causar o envelhecimento artificial, todos os rostos foram embranquecidos.

Com exceção dos mais curiosos, ninguém roda o filtro cinco vezes na mesma imagem. A ideia do experimento é usar o app de forma extrema para mostrar a ação do algoritmo. A cada execução, o filtro embranquece ligeiramente o rosto na imagem. Somadas, as camadas de embranquecimento têm resultado impactante.

Além disso, o experimento mostra que até numa única aplicação do filtro – o tipo de uso esperado da maioria dos usuários –, é possível notar também o branqueamento dos rostos. Mesmo sútil, isso demonstra problemas. “A alteração na qualidade da pele, seja a cor, o viço ou a quantidade de rugas, não acontece na mesma proporção nas pessoas brancas e não brancas”, diz Nicea Quintino Amauro, presidente da Associação Brasileira de Pesquisadores Negros (ABPN). “Essas mudanças podem torná-las diferentes dos grupos étnicos a que pertencem”, diz.

Não é a primeira vez que o aplicativo mostra esse tipo de viés. Em abril de 2017, o FaceApp oferecia um app de embelezamento, chamado “hot” (algo como “atraente”), que acabava embranquecendo os usuários. A ferramenta foi criticada em redes sociais e forçou a empresa a pedir desculpas e a rebatizar o filtro para “spark” (algo como “fagulha”). Na época, Yaroslav Goncharov, fundador da companhia dona do FaceApp, disse: “É um efeito colateral da rede neural que foi treinada com dados enviesados. Não era o comportamento planejado”.

Como antes, o problema parece estar nos dados utilizados pela inteligência artificial do FaceApp responsável por criar o efeito de envelhecimento. Os detalhes entregam que há algo desequilibrado. “O app diminui o lábio das pessoas. E isso é uma incoerência. O volume dos lábios de pessoas negras não diminui com o envelhecimento”, diz Amauro.

Um algoritmo de inteligência artificial tem um princípio básico: ele necessita de um grande banco de dados, com milhares de exemplos, para que aprenda a detectar padrões e aprenda a realizar sozinho as atividades para as quais foi destinado. Assim, é possível afirmar que o banco de imagens do FaceApp é composto em grande parte por rostos envelhecidos de pessoas brancas. Ao criar o efeito de envelhecimento, o algoritmo pode estar levando a cor de pele como um fator de envelhecimento.

Mas isso é difícil saber com precisão: algoritmos de inteligência artificial tomam decisões e tiram conclusões sozinhos, sem auxílio humano. Até o momento, apenas um exemplo de embranquecimento foi mostrado. Contudo, o resultado da aplicação repetida do filtro foi similar nos 12 experimentos realizados.

“Os resultados aberrantes são resultado a princípio da omissão dos criadores, que teriam esquecido de testar em públicos mais diversos e treinar melhor a base”, diz Tarcízio Silva, cofundador do Instituto Brasileiro de Pesquisa e Análise de Dados. Para os especialistas, o FaceApp tinha que ter sido mais cuidadoso na criação do banco de dados, uma atividade que passa pelo crivo humano.

“Isso já aconteceu em filtros do Snapchat também. Acham que causando embranquecimento vão levar a um padrão de beleza. Não temos nenhuma vontade de nos padronizar”, diz Érica Ribeiro, parte do coletivo Influência Negra, que reúne influenciadores e criadores de conteúdo negros. “O reconhecimento facial e a análise de dados pode ser um dosador social, parte do racismo”, diz.

As comparações abaixo mostram o antes e depois dos 12 experimentos, todos utilizando cinco aplicações do filtro de envelhecimento:

Preconceito das máquinas?

O preconceito de um aplicativo popular é apenas a ponta do iceberg de uma questão que deverá ser enfrentada nos próximos anos pela sociedade. “Reconhecimento facial, sistemas de pontuação de crédito, análise de candidatos ou escores de risco criminal são também desenvolvidos e aplicados sem muita reflexão”, lembra Silva.

Nos EUA, há o caso de um sistema de inteligência artificial usado para prever reincidência criminal, batizado de Compas, que é mais rigoroso com negros do que brancos. Da mesma maneira, o sistema de reconhecimento facial da Amazon, chamado Rekognition, já foi acusado de ter uma performance pior para reconhecer mulheres e negros. O Rekognition é usado por diversas forças de segurança dos EUA, incluindo o sistema de imigração (ICE, a sigla em inglês).

No Brasil, algo do tipo já acontece. No começo de julho, o reconhecimento facial do Rio de Janeiro levou uma mulher inocente para a delegacia – o sistema a confundiu com uma outra mulher que já estava presa. “Existe a ideia hiperliberal de que tecnologias seriam mais neutras ou objetivas. Não são. Tecnologias como aplicativos e mídias sociais, que não podem ser auditadas, eventualmente podem ser construídas de modo a prejudicar intencionalmente determinados grupos”, diz Silva.

“Mesmo quando isso não é intencional, pode haver impactos negativos por serem sistemas construídos ou treinados com procedimentos e dados injustos”, diz Silva. Uma das ideias para evitar algoritmos preconceituosos está por trás do princípio representado pela FAT – um acrônimo em inglês para equidade, responsabilidade e transparência. Ou seja, algoritmos devem tratar todos de maneira igual e as empresas devem ser responsáveis e transparentes sobre os seus algoritmos.

O princípio é discutido em todo o mundo por especialistas da área. “A inteligência artificial tem que ter padrão ético e não pode prejudicar as pessoas”, diz Carvalho. Esse tipo de discussão deve se estender pelos próximos anos. “Se o recurso não consegue tratar pessoas diferentes com a mesma qualidade, ele não é bem-vindo”, diz Amauro.

Ao que parece, embora tenha filtro de envelhecimento, o FaceApp ainda tem muito a amadurecer.